GeForce 9600 GT

Вступление

Началось все довольно прозаично - с обновления линейки среднего уровня графических чипсетов NVIDIA. Впрочем, несмотря на тот же "порядковый номер" видеокарты, что и у флагманской линейки, адаптер на базе нового GPU, получившего индекс G92, все же позиционируется разработчиком именно как middle-end решение.

Прежде всего, G92 производится по новому 65-нм техпроцессу, что позволило поднять частоты до 600-650 МГц по чипу (стандартные для G80 равны 575 МГц) и при этом уменьшить энергопотребление. Кроме частоты увеличилось и количество унифицированных процессоров - до 112 штук против 96-ти у GeForce 8800 GTS 640/320 MB (GeForce 8600 вспоминать вообще нет смысла). Сравнение со 128-ю процессорами в чипе GeForce 8800 GTX/Ultra было бы некорректно, поскольку это топовые видеокарты, которые по цене отличаются от 8800 GT 512 Мб очень уж сильно, хотя по быстродействию новый middle-end иногда дотягивает и до флагмана компании.

Дальше NVIDIA отказалась от экспериментов с 320- и 384-битной шиной памяти, на данный момент 256 бит вполне достаточно для процессора такой мощности, а на цену конечного продукта этот параметр влияет очень заметно. Осталось добавить, что стандартной частотой памяти для GeForce 8800 GT 512 Мб считается 1800 МГц (эффективная), а в качестве интерфейса используется PCI Express 2.0, который, как мы уже знаем, раскрывается во всей красе при использовании "тандемов" видеокарт (в случае с NVIDIA - режим SLI).

Но после представления дорогих (относительно) видеокарт среднего уровня на базе G92 образовалась пустота между GeForce 8800 GT и GeForce 8600 GTS, которую необходимо было чем-то заполнить. И для этих целей как раз подходит новый графический процессор G94, изначально предназначенный для middle-end-акселераторов ценой до 200 долларов, в которую уже неплохо вписываются ATI Radeon 3870/3850.

NVIDIA GeForce 9600 GT

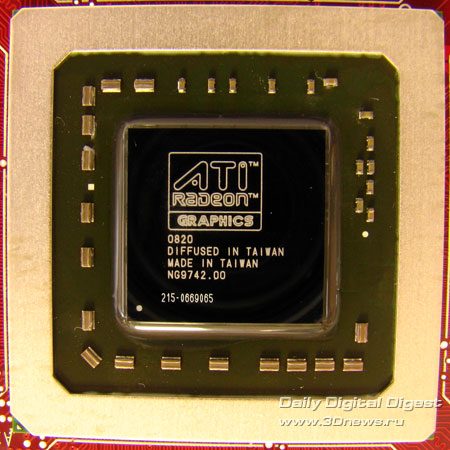

Итак, что же собой представляет GeForce 9600 GT на базе G94, представленный 21 февраля сего года? Первое, что обращает на себя внимание - новая серия линейки GeForce. Как мы помним, NVIDIA сперва представляла чипсет high-end класса, а уже позже - более доступные решения. В данном случае серия GeForce 9xxx начала свой отсчет именно с решения среднего уровня, причем, с весьма заманчивой ценой. Следом уже идет внешний вид графического процессора - кристалл развернут на 45°.

Ну и наконец, технические характеристики, которые не сильно отличаются от таковых известного нам G92. Фактически, G94 можно назвать производным от старшего GPU: тот же 65-нм техпроцесс, благодаря чему удалось поднять частоту ядра до 650 МГц; архитектура, позаимствовавшая все самое лучшее из G80 и G84; 256-битный интерфейс памяти; поддержка шины PCI Express 2.0; новый видеопроцессор PureVideo HD, отвечающий за обработку видео высокой четкости.

Существенным отличием является уменьшенное количество потоковых процессоров, а значит, и транзисторов - в G94 стрим-процессоров всего 64 (в G92 - 112), причем функционируют они на частоте 1625 МГц, транзисторов - около 505 млн. Также сократилось количество текстурных блоков до 32 (в G92 их 56), но из-за архитектурных особенностей они не смогут работать быстрее 32 TMU в G80. Скорее, скорость работы TMU в новом чипе можно приравнять к 16 текстурникам флагмана компании, но только условно. Число ROP осталось неизменным по сравнению с G92 - все те же 16 штук. Как видим по характеристикам, новое доступное решение среднего класса имеет вдвое большее количество функциональных блоков и шину памяти в отличие от GeForce 8600 GTS, который, вскоре, должен спустится до уровня "кому за 100, но нет еще 150", долларов, естественно. Теперь относительно памяти. Как и GeForce 8800 GT, новые акселераторы поддерживают 512 МБ GDDR3 частотой 1800 МГц, что с 256-битной шиной дает возможность перекачки данных до 57,6 ГБ в секунду - ранее невиданная скорость для подобных решений.

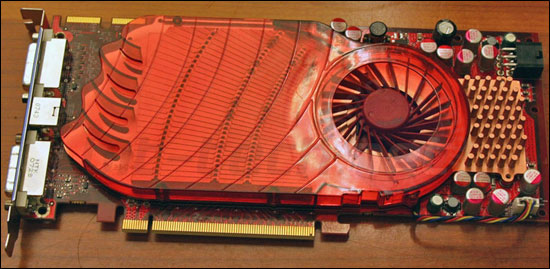

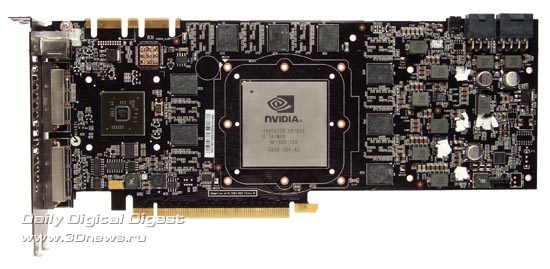

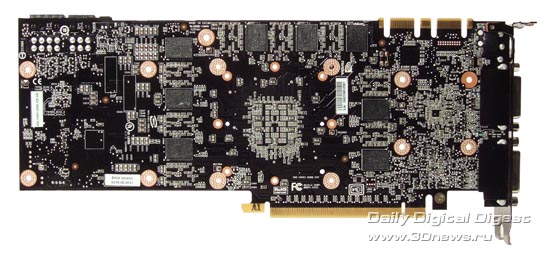

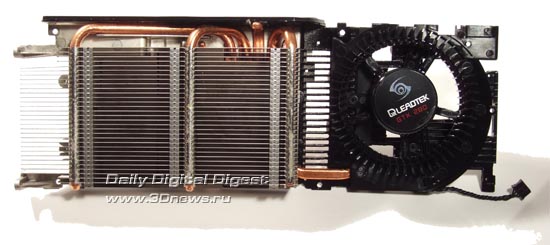

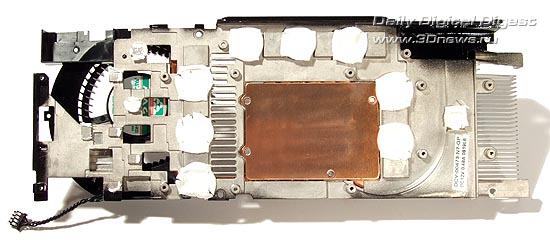

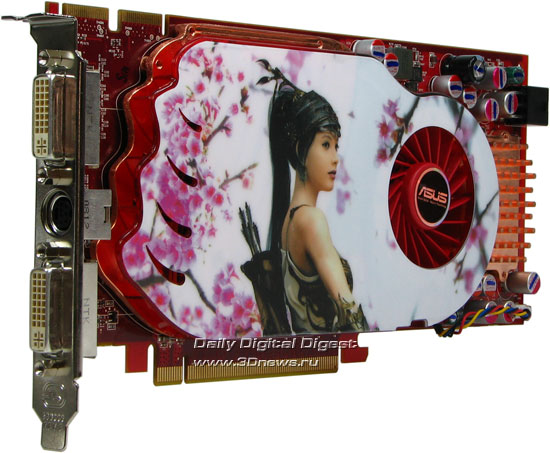

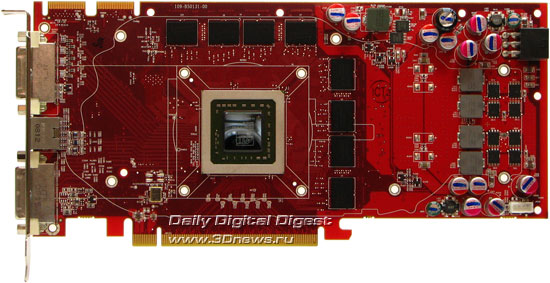

Дизайн PCB эталонных карт на базе GeForce 9600 GT немного упрощен по сравнению с GeForce 8800 GT, но разводка памяти осталась прежней. Силовая обвязка также немного сбросила в весе - заявленное энергопотребление составляет всего 95 Вт, но, несмотря на поддержку PCI-E 2.0, карты оснащаются дополнительным разъемом питания. Референсная система охлаждения представляет собой все тот же однослотовый кулер, накрывающий плату целиком, с вентилятором большого диаметра, как на СО второй ревизии от GeForce 8800 GT. Монтажные отверстия совместимы с таковыми на GeForce 7900, так что, заменить в случае необходимости систему охлаждения на альтернативную не составит труда.

Стоит также отметить поддержку новым GPU интерфейсов HDMI и DisplayPort, причем последний реализован в самом чипе, в отличие от G92. Сами порты могут быть выполнены либо на картах специального дизайна, либо посредством переходника, подключаемого к одному из двух Dual Link DVI. Для передачи звука транзитом, на картах предусмотрен специальный разъем.

Тестовая конфигурация

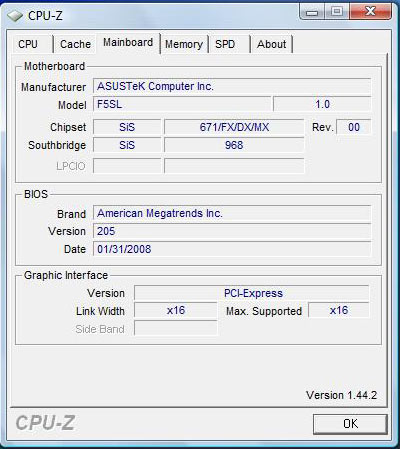

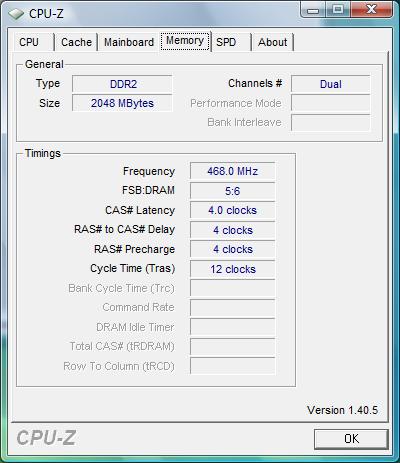

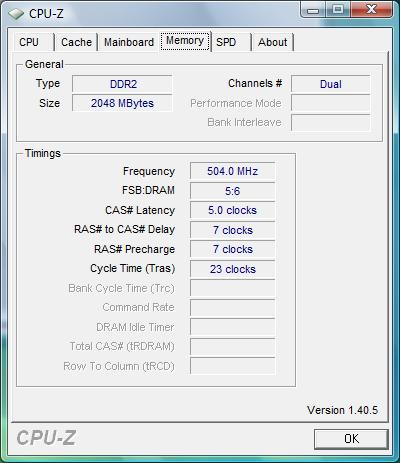

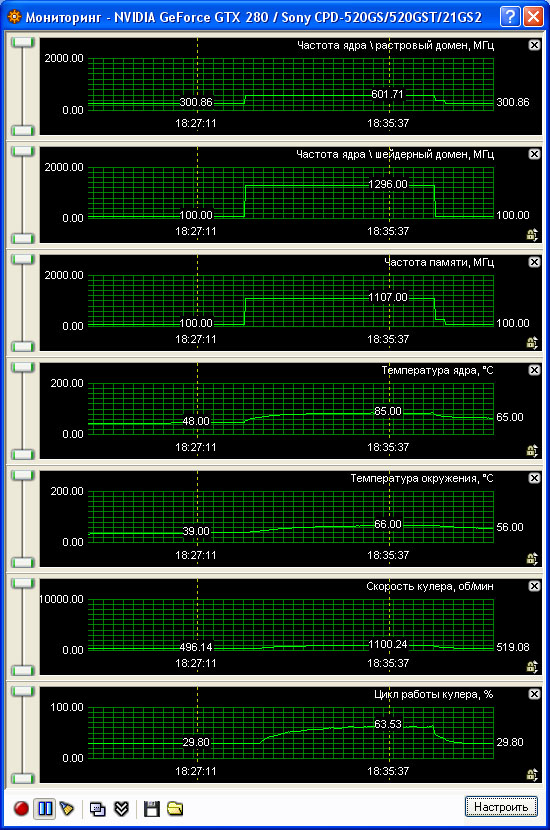

Для тестов использовалась система на базе материнской платы ECS P35T-A (чипсет Intel P35), процессора Core 2 Extreme QX6700 и двух планок DDR2-800 по 1 ГБ производства Hynix. Все это добро управлялось операционной системой Windows Vista Enterprise со всеми обновлениями на текущий момент. В качестве оппонентов были выбраны Zotac GeForce 8800 GT AMP! (рабочие частоты 700/1675/2000 МГц) и ECS N8800GTS-640MX с референсными характеристиками.

Как видите на снимке сверху, GeForce 9600 GT и GeForce 8800 GT идентичны по размерам, как и системы охлаждения.

В качестве бенчмарков были взяты следующие программы:

3Dmark'06. Традиционный тестовый пакет, без которого, как без рук. Тестирование проводилось в двух режимах: 1280х1024 без дополнительных опций и в 1600х1200 с 8х антиалиасингом и 16х анизотропией, максимум того, что позволяет 3Dmark'06;

Gears of War. Игра от Epic, создателей движка Unreal Engine 3, и, собственно, на этом движке и основана. Обильное использование постэффектов, бамп-мэппинг и повсеместное использование карт смещения для отрисовки персонажей. В общем, именно такими будут ближайшие шутеры, портированные с Xbox 360, а их готовится к выходу немало. Настройки - полный максимум при разрешении 1280х1024, только вертикальная синхронизация отключена;

Lost Planet: Extreme Conditions. Хотя сама игра и не оправдала всех ожиданий, буйство погодных эффектов и тени от DirectX 10 вызывают уважение. Настройки, как и в предыдущем случае, максимальные, разрешение 1280х768 (широкоформатное);

Supreme Commander. Для бенчмарка важно то, что в SC на свободно масштабируемой карте, размером до 80х80 км, умещается несколько тысяч юнитов, не шибко обделенных полигонами. Все это приправлено реалистичными тенями и десятками различных взрывов (благо, взрывать в этой игре есть что). В разрешении 1280х1024 и восьмикратным сглаживанием SC способен заставить "задуматься" любую видеокарту. Изрядная нагрузка ложится и на процессор, но у нас с этим более-менее в порядке;

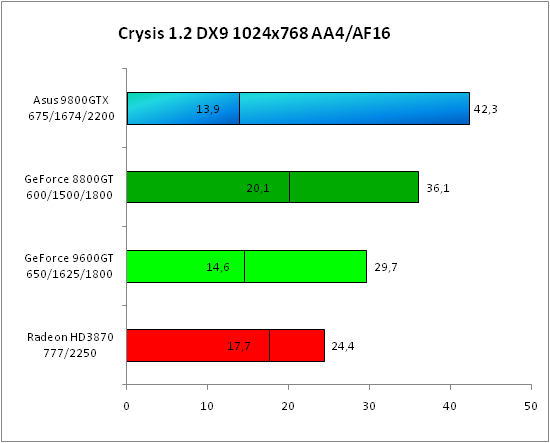

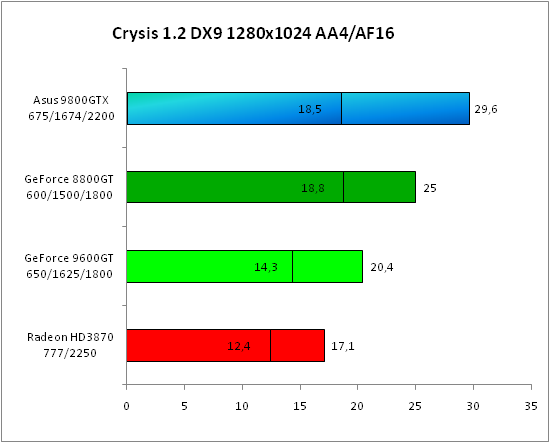

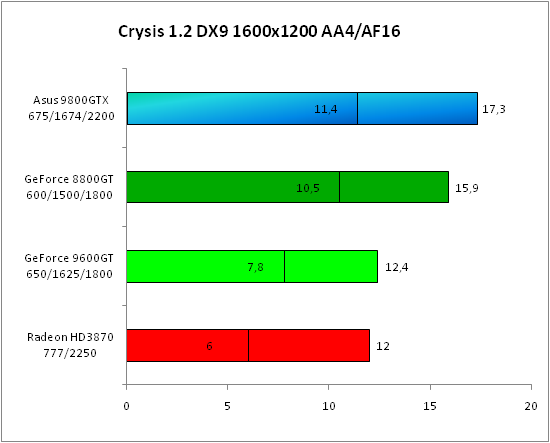

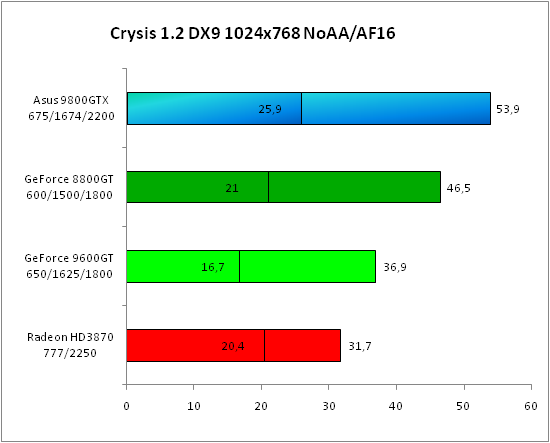

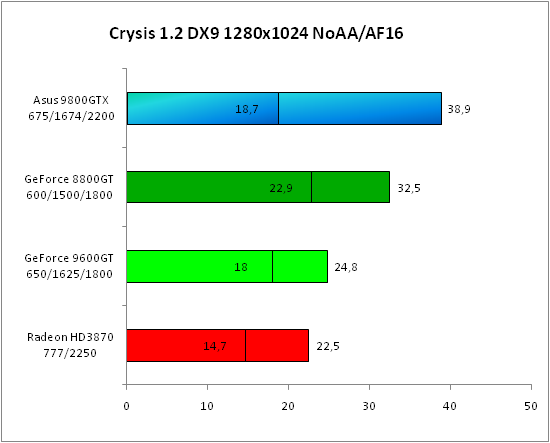

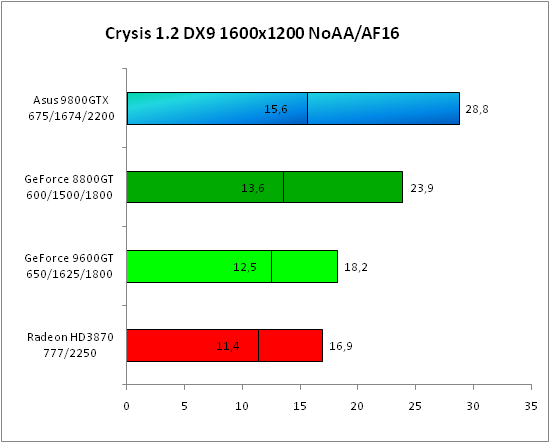

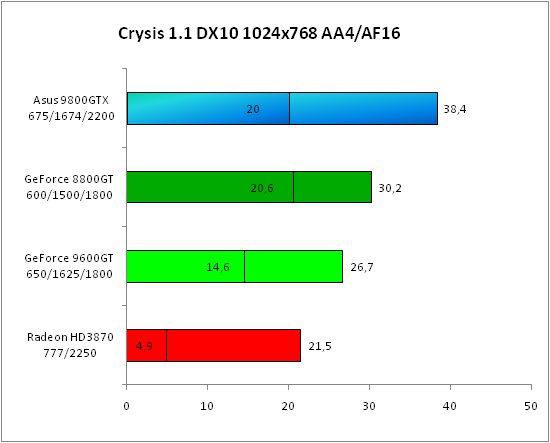

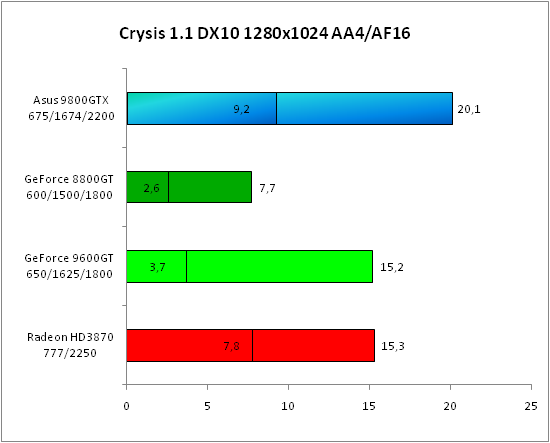

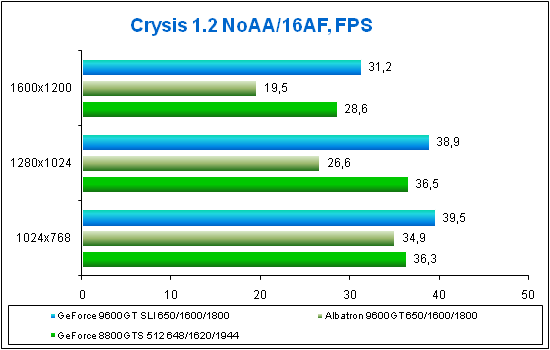

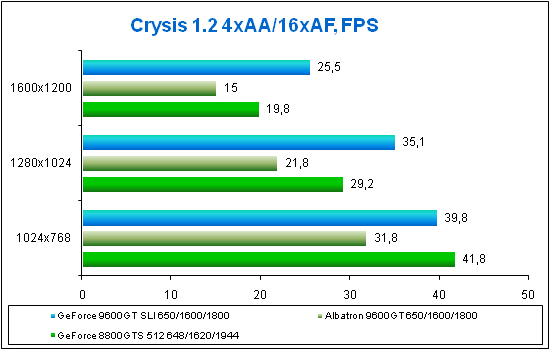

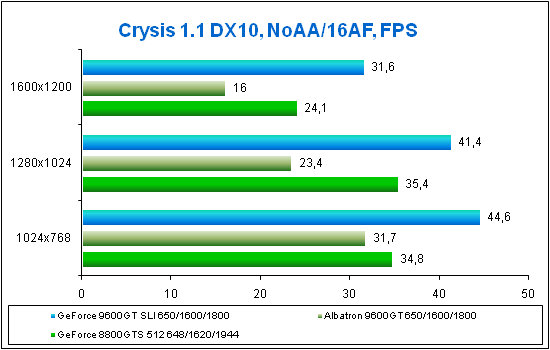

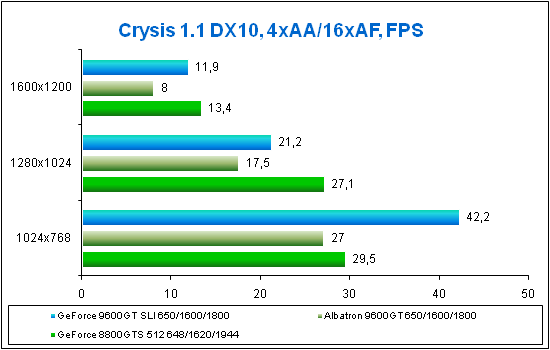

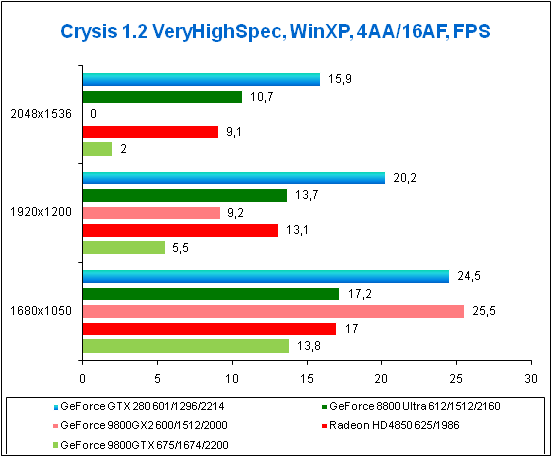

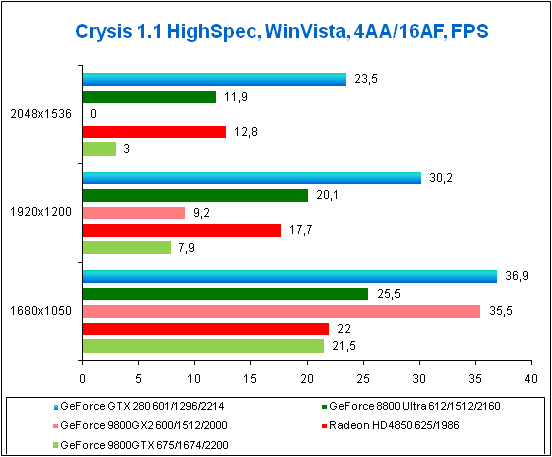

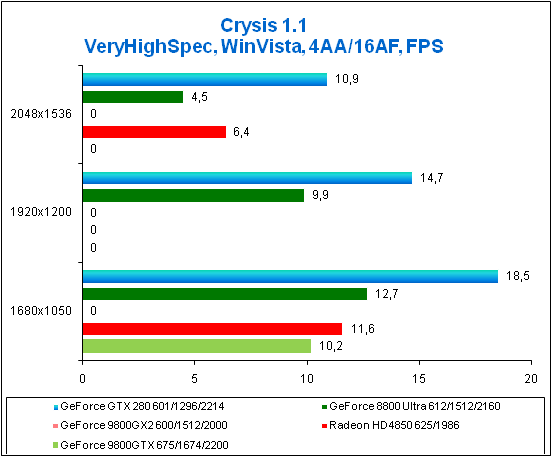

Crysis. Без комментариев, пожалуй. Единственный "чистый" DirectX 10 шутер на РС в комментариях действительно не нуждается. Настройки High.

Просто "из интереса" была проведена проверка производительности встроенным средством Windows Vista, но она всем картам выдала 5.9 балла, так что говорить тут не о чем.

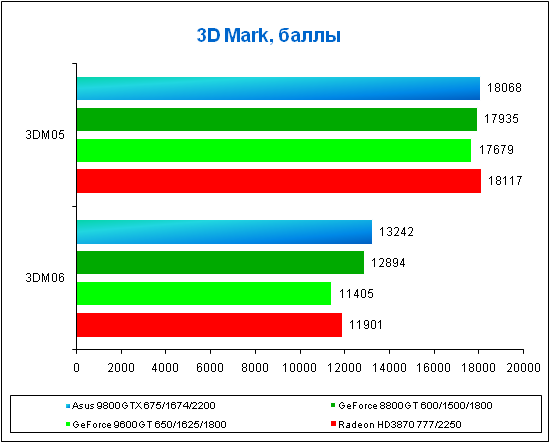

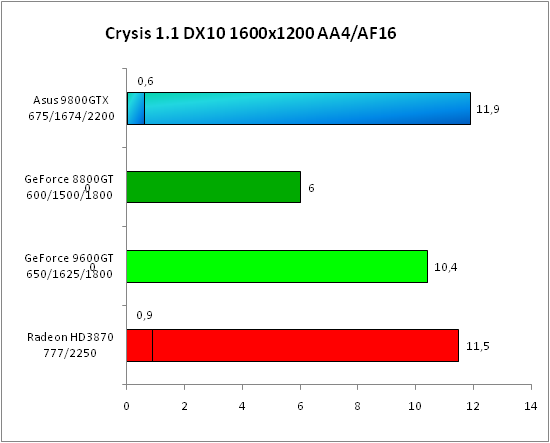

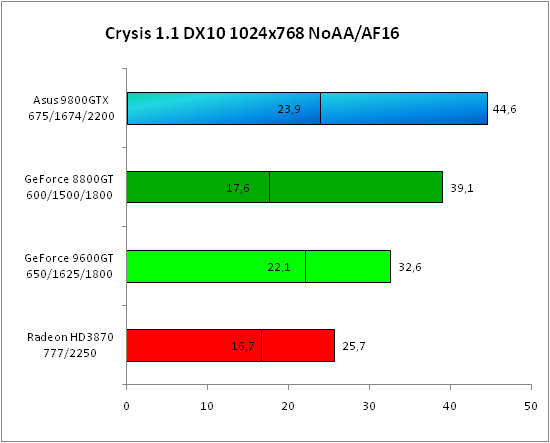

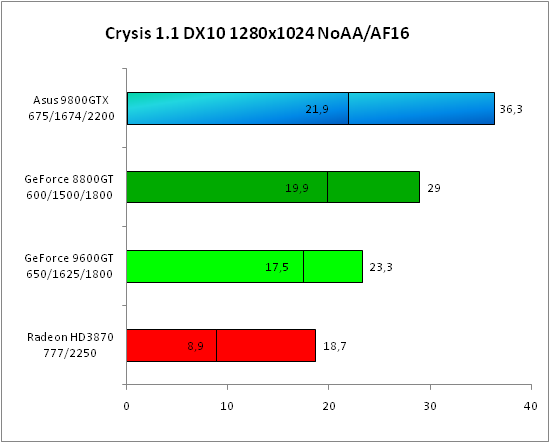

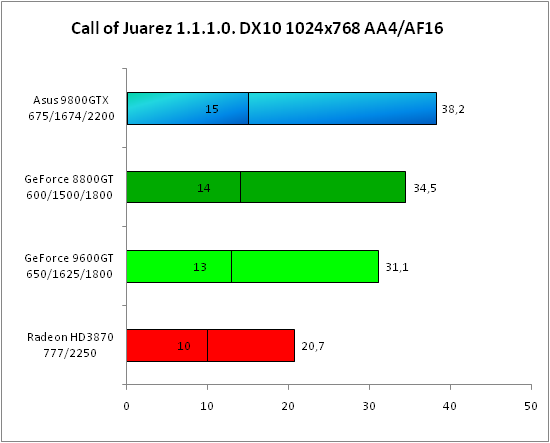

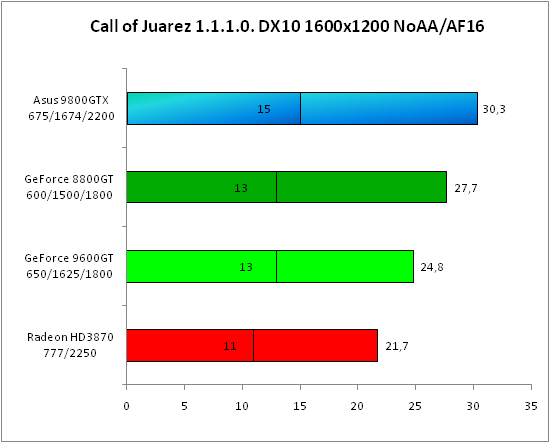

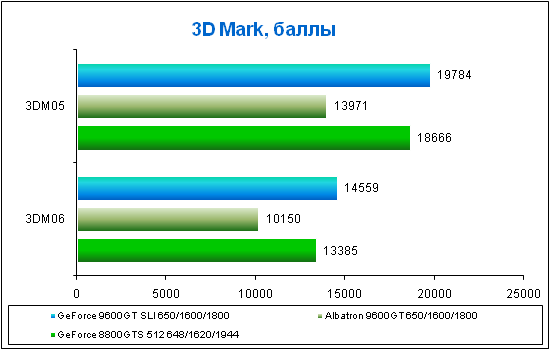

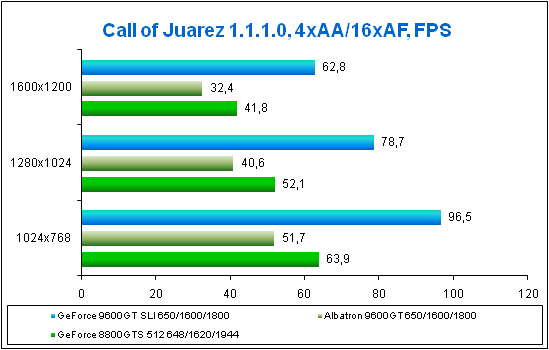

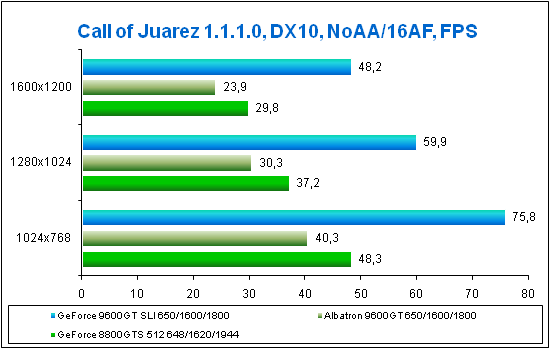

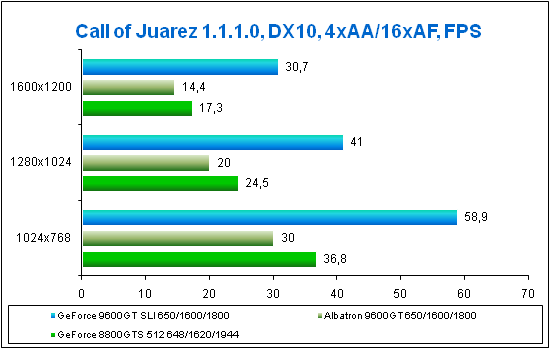

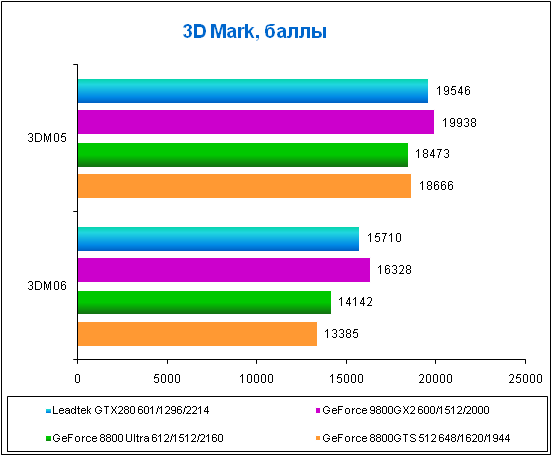

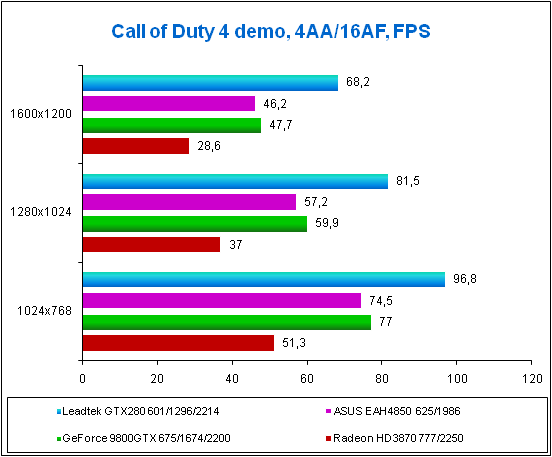

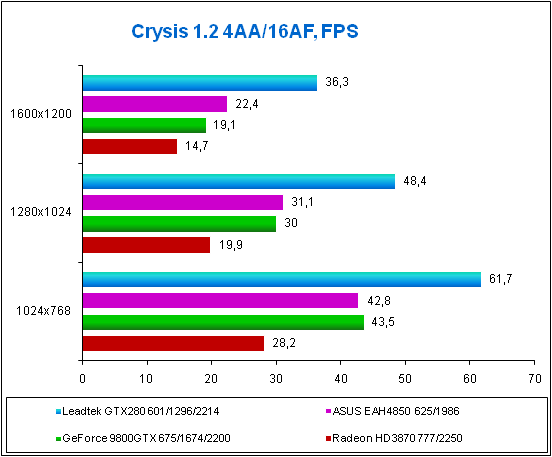

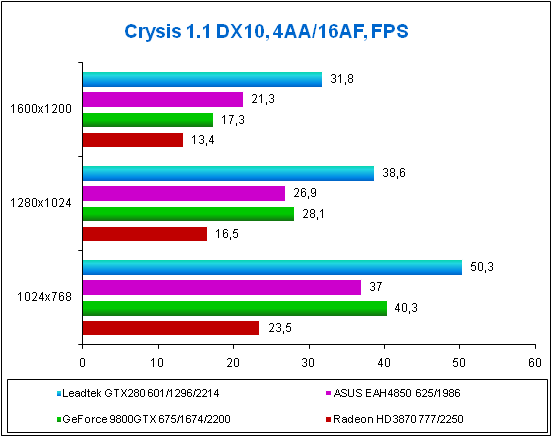

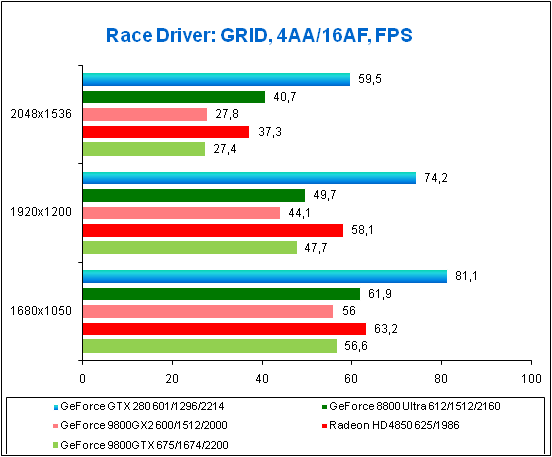

Результаты

Любопытные результаты, включи в тестирование GeForce 8600 GTS - было б с чего посмеяться. А тут, как видите, просто говорить не о чем - производительный DirectX 10 по разумной цене (будем надеяться, что ажиотаж не взвинтит цены до небес). Конечно, не стоит забывать, что "гвоздь программы" имеет заводской разгон, как и представитель GeForce 8800 GT. Да и тестирование является предварительным. Но даже с такими показателями уже становится интересно кто выйдет победителем в на рынке middle-end решений.

Выводы

Ясно, что неутешительным итог будет, прежде всего, для предыдущего поколения видеокарт NVIDIA. Когда есть GeForce 8800 GT 512 Мб, который и дешевле (по крайней мере, так было задумано) и быстрее GeForce 8800 GTS 640 Мб, то думать тут нечего - выбор очевиден. Но тут, как черт из табакерки, появляется GeForce 9600 GT, который вроде бы должен быть видеокартой "среднего класса", но при этом он вплотную приближается к "элите". Да, до GeForce 8800 Ultra новичок не дотянет даже при хорошем разгоне, но ведь эта видеокарта почти в три раза дешевле и гораздо экономичнее (а значит - и тише)! Вопрос "а не собрать ли у себя SLI" становится еще более актуальным.

GeForce 8600 GTS/GT забыт, как страшный сон, у нас теперь новый middle-end с ценой до $200, который позволит насладиться игровым процессом без каких-либо тормозов при более агрессивных настройках. Собственно, как это и было во времена GeForce 7600.

Не можем не отметить бренд Zotac. Продукция компании понравилась практически всем - и качеством, и комплектацией, и удобством установки драйверов, и внешним видом. При этом - ничего заведомо лишнего, но все необходимое на месте. В общем, если цена на Zotac 9600 GT AMP! не будет сильно превышать стоимости аналогичных предложений, то данная карта станет отличным выбором для требовательного пользователя.

Авторы: Bateau, Qntality

Источник : overclockers.com.ua

![Питерский клан [OPEX] по игре в CS 1.6](http://upforme.ru/uploads/0000/35/2d/945-1.gif)